作为人工智能领域的领军企业,英伟达有着强大的技术实力和广泛的应用场景,在过去一年中,生成式 AI 的需求爆发为其带来了巨大的增长机遇。

根据富国银行的统计,英伟达目前在数据中心 AI 市场拥有 98% 的市场份额,而 AMD 仅有 1.2% 的市场份额,英特尔则只有不到 1%。

由于英伟达的 AI 芯片价格高昂,且存在着供应不足的问题,这也迫使一些客户希望选择其他的替代产品。在竞争对手林立的同时,英伟达也正不断推动产品研发和加快更新迭代速度。

近日,servethehome 披露了英伟达的数据中心产品路线图,展示了英伟达面向人工智能市场的产品规划,将推出 H200、B100 和 X100 等多款 GPU。

英伟达正计划增加面向数据中心市场的产品种类,推出多款面向 AI 计算和 HPC 的产品,让不同的客户可以有针对性购买产品,降低购买芯片难度。通过架构图可以看到,未来英伟达将会对基于 Arm 架构的产品和基于 x86 架构的产品分开。

H200:2024 年第二季度开始供货

2023 年 11 月 13 日,英伟达宣布推出 NVIDIA HGX H200,为全球领先的 AI 计算平台带来强大动力。该平台基于 NVIDIA Hoppe 架构,配备 NVIDIA H200 Tensor Core GPU 和高级内存,可处理生成 AI 和高性能计算工作负载的海量数据。H200 将于 2024 年第二季度开始向全球系统制造商和云服务提供商供货。

NVIDIA H200 是首款提供 HBM3e 的 GPU,HBM3e 具有更快、更大的内存,可加速生成式 AI 和大型语言模型,同时推进 HPC 工作负载的科学计算。借助 HBM3e,NVIDIA H200 以每秒 4.8 TB 的速度提供 141GB 内存,与前身 NVIDIA A100 相比,容量几乎翻倍,带宽增加 2.4 倍。

英伟达表示,H200 可以部署在各种类型的数据中心中,包括本地、云、混合云和边缘。

L40S:2023 年秋季推出

L40S 是英伟达最强大的 GPU 之一,其在 2023 年推出,其旨在处理下一代数据中心工作负载:生成式 AI、大型语言模型(LLM)推理和训练,3D 图形渲染、科学模拟等场景。

与前一代 GPU(如 A100 和 H100)相比,L40S 在推理性能上提高了高达 5 倍,在实时光线追踪(RT)性能上提高了 2 倍。内存方面,它配备 48GB 的 GDDR6 内存,还加入了对 ECC 的支持,在高性能计算环境中维护数据完整性还是很重要的。

L40S 配备超过 18,000 个 CUDA 核心,这些并行处理器是处理复杂计算任务的关键。L40S 更注重可视化方面的编解码能力,而 H100 则更专注于解码。尽管 H100 的速度更快,但价格也更高。

GH200/GH200NVL:2024 年第二季度投产

2023 年 8 月,英伟达宣布推出新一代 GH200 Grace Hopper 超级芯片,新芯片将于 2024 年第二季投产。

NVIDIA GH200,结合了 H200 GPU 和 Grace CPU,将 Hopper 架构 GPU 和 Arm 架构 Grace CPU 结合,使用了 NVLink-C2C 将两者连接起来。每个 Grace Hopper Superchip 包含了 624GB 的内存,其中有 144GB 的 HBM3e 和 480GB 的 LPDDR5x 内存。

GH200 和 GH200NVL 将使用基于 Arm 的 CPU 和 Hopper 解决大型语言模型的训练和推理问题。GH200NVL 采用了 NVL 技术,具有更好的数据传输速度。

此外,「B」系列 GPU 也有望在 2024 年下半年推出,替代之前的第九代 GPU Hopper。

B100、B40、GB200、GB200NVL 也将在 2024 推出

英伟达计划推出用基于 x86 架构的 B100 接替 H200,计划用基于 ARM 架构的推理芯片 GB200 替代 GH200。此外,英伟达也规划了 B40 产品来替代 L40S,以提供更好的面向企业客户的 AI 推理解决方案。

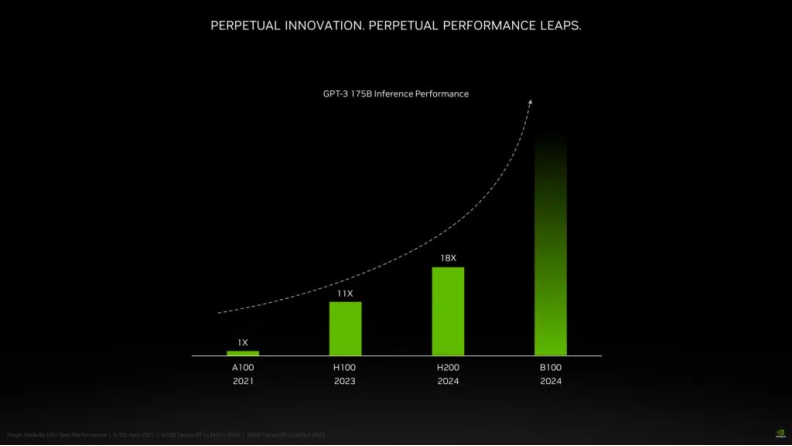

根据英伟达公布的信息,该公司计划于 2024 年发布 Blackwell 架构,而采用该架构的 B100 GPU 芯片预计将大幅提高处理能力,初步评估数据表明,与现有采用 Hopper 架构的 H200 系列相比,性能提升超过 100%。这些性能提升在 AI 相关任务中尤为明显,B100 在 GPT-3 175B 推理性能基准测试中的熟练程度就证明了这一点。

X100 计划 2025 年发布

英伟达还披露了 X100 芯片的计划,计划于 2025 年发布,该芯片将扩大产品范围,包括企业用途的 X40 和 GX200,在 Superchip 配置中结合 CPU 和 GPU 功能。同样,GB200 预计将效仿 B100,融入超级芯片概念。

从英伟达的产品路线来看,在未来 1-2 年,AI 芯片市场将再次天翻地覆。

在英伟达占据绝对地位的 AI 芯片领域中,AMD 是为数不多具备可训练和部署 AI 的高端 GPU 公司之一,业界将其定位为生成式 AI 和大规模 AI 系统的可靠替代者。AMD 与英伟达展开竞争的战略之一,就包括功能强大的 MI300 系列加速芯片。当前,AMD 正在通过更强大的 GPU、以及创新的 CPU+GPU 平台直接挑战英伟达 H100 的主导地位。

AMD 最新发布的 MI300 目前包括两大系列,MI300X 系列是一款大型 GPU,拥有领先的生成式 AI 所需的内存带宽、大语言模型所需的训练和推理性能;MI300A 系列集成 CPU+GPU,基于最新的 CDNA 3 架构和 Zen 4 CPU,可以为 HPC 和 AI 工作负载提供突破性能。毫无疑问,MI300 不仅仅是新一代 AI 加速芯片,也是 AMD 对下一代高性能计算的愿景。

MI300X 加速卡已在 2023 年推出

AMD MI300X 拥有最多 8 个 XCD 核心,304 组 CU 单元,8 组 HBM3 核心,内存容量最大可达 192GB,相当于英伟达 H100(80GB)的 2.4 倍,同时 HBM 内存带宽高达 5.3TB/s,Infinity Fabric 总线带宽 896GB/s。拥有大量板载内存的优点是,只需更少的 GPU 来运行内存中的大模型,省去跨越更多 GPU 的功耗和硬件成本。

2023 年 12 月,AMD 在推出旗舰 MI300X 加速卡之外,还宣布 Instinct MI300A APU 已进入量产阶段,预估 2024 年开始交付,上市后有望成为世界上最快的 HPC 解决方案。

MI300A:预估 2024 年开始交付

MI300A 是全球首款适用于 HPC 和 AI 的数据中心 APU,结合了 CDNA 3 GPU 内核、最新的基于 AMD「Zen 4」x86 的 CPU 内核以及 128GB HBM3 内存,通过 3D 封装和第四代 AMD Infinity 架构,可提供 HPC 和 AI 工作负载所需的性能。与上一代 AMD Instinct MI250X5 相比,运行 HPC 和 AI 工作负载,FP32 每瓦性能为 1.9 倍。

能源效率对于 HPC 和 AI 领域至关重要,因为这些应用中充斥着数据和资源极其密集的工作负载。MI300A APU 将 CPU 和 GPU 核心集成在一个封装中,可提供高效的平台,同时还可提供加速最新的 AI 模型所需的训练性能。在 AMD 内部,能源效率的创新目标定位为 30×25,即 2020-2025 年,将服务器处理器和 AI 加速器的能效提高 30 倍。

综合来看,全球 AI 热潮在 2023 年开始爆发,2024 年将继续成为业界的焦点。与 2023 年不同的是,过去在 AI HPC 领域占据主导地位的英伟达,今年将面临 AMD MI300 系列产品的挑战。

由于微软、Meta 等云端服务大厂在一两年前就开始陆续预订英伟达的 MI300 系列产品,并要求 ODM 厂商开始设计专用的 AI 服务器,使用 MI300 系列产品线,以分散风险和降低成本。业界预计,今年 AMD 的 MI300 系列芯片市场需求至少达到 40 万颗,如果台积电提供更多的产能支持,甚至有机会达到 60 万颗。

AMD 的 CEO 苏姿丰在圣何塞举办的 AMD Advancing AI 活动上谈到,包括 GPU、FPGA 等在内的数据中心加速芯片,未来四年每年将以 50% 以上的速度增长,从 2023 年的 300 亿市场规模,到 2027 年将超过 1500 亿。她表示,从业多年,这种创新速度比她以往见到的任何技术都快。

根据富国银行的预测,AMD 虽然在 2023 年的 AI 芯片的营收仅为 4.61 亿美元,但是 2024 年将有望增长到 21 亿美元,将有望拿到 4.2% 的市场份额。英特尔也可能拿到将近 2% 的市场份额。这将导致英伟达的市场份额可能将小幅下滑到 94%。

不过,根据苏姿丰在 1 月 30 日的电话会议上公布的数据显示,AMD 在 2023 年四季度的 AI 芯片营收已经超越此前预测的 4 亿美元,同时 2024 年 AMD 的 AI 芯片营收预计也将达到 35 亿美元,高于先前预测的 20 亿美元。如果,AMD 的预测数据准确的话,那么其 2024 年在 AI 芯片市场的份额有望进一步提高。

当然,英伟达也并不会放任其在 AI 市场的垄断地位受到侵蚀。在目前的人工智能智能加速芯片市场,英伟达的 A100/H100 系列 AI GPU 虽然价格高昂,但一直是市场的首选。今年英伟达更为强大的 Hopper H200 和 Blackwell B100 也将会上市。而根据一些研究机构的预测,英伟达计划今年销售约 150 万至 200 万个 AI GPU,这可能将是其 2023 年销量的三倍,这也意味着英伟达将会彻底解决供应的瓶颈问题,面对 AMD 和英特尔的竞争,届时英伟达的价格策略可能也会有所调整。

英伟达要面对的不仅仅是 AMD,如今自研 AI 芯片的风潮正在科技巨头之间兴起。

今年 2 月,科技巨头 Meta Platforms 对外证实,该公司计划今年在其数据中心部署最新的自研定制芯片,并将与其他 GPU 芯片协调工作,旨在支持其 AI 大模型发展。

研究机构 SemiAnalysis 创始人 Dylan Patel 表示,考虑到 Meta 的运营规模,一旦大规模成功部署自研芯片,有望将每年节省数亿美元能源成本,以及数十亿美元芯片采购成本。

OpenAI 也开始寻求数十亿美元的资金来建设人工智能芯片工厂网络。

外媒报道,OpenAI 正在探索制造自己的人工智能芯片。并且 Open AI 的网站开始招募硬件相关的人才,官方网站上有数个软硬件协同设计的职位在招聘,同时在去年九月 OpenAI 还招募了人工智能编译器领域的著名牛人 Andrew Tulloch 加入,这似乎也在印证 OpenAI 自研芯片方面的投入。

不止是 Meta 和 OpenAI,据 The Information 统计,截至目前,全球有超过 18 家用于 AI 大模型训练和推理的芯片设计初创公司,包括 Cerebras、Graphcore、壁仞科技、摩尔线程、d-Matrix 等,融资总额已超过 60 亿美元,企业整体估值共计超过 250 亿美元(约合 1792.95 亿元人民币)。

这些公司背后的投资方包括红杉资本、OpenAI、五源资本、字节跳动等。如果加上微软、英特尔、AMD 等科技巨头和芯片龙头的「造芯」行动,对标英伟达的 AI 芯片企业数量最终就将超过 20 家。

如此来看,尽管英伟达在数据中心、游戏和人工智能加速器等关键增长领域保持着引人注目的技术领导地位,但公司面临越来越多的竞争威胁。2024 年英伟达也必然会面临更大的挑战。

*声明:本文系原作者创作。文章内容系其个人观点,我方转载仅为分享与讨论,不代表我方赞成或认同,如有异议,请联系15950995158。